您現在的位置是:首頁 >綜合 > 2021-04-30 10:57:49 來源:

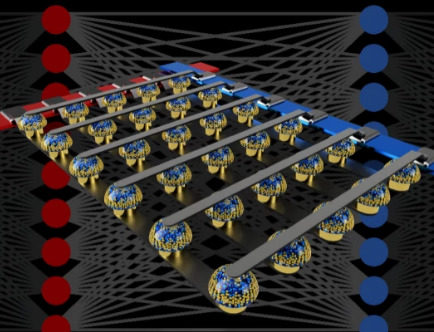

IBM研究人員為AI培訓設計了一種快速高能效的芯片

得益于強大的圖形芯片和分布式計算的進步,優化人工智能核心的算法比以往任何時候都更容易。但它在當今的硬件上并不是特別有效 - 即使是功能強大的GPU也需要數天或數周的時間來訓練神經網絡。

這促使IBM的研究人員開發出一種專為AI培訓量身定制的新芯片。在Nature雜志上發表的一篇 名為 “使用模擬存儲器的等效精度加速神經網絡訓練”的論文中,他們描述了一種晶體管和電容器系統,可以快速,精確,高效地訓練神經網絡。

神經網絡由稱為神經元或節點的互連單元(節點集合稱為層)組成,它們接收數字輸入。在基本網絡中,單個神經元將這些輸入乘以一個值 - 一個權重 - 并將它們傳遞給激活函數,激活函數定義節點的輸出。通過稱為反向傳播的策略,權重隨時間調整,提高了輸出的準確性。

GPU非常適合這些,因為與傳統處理器不同,后者按順序處理數字,它們能夠并行執行大量計算。但是因為圖形芯片中的處理器和內存在主板上相互間隔很遠,所以當數據在它們之間來回切換時會引入延遲。

“傳統計算機[消耗]消耗大量能源,”領導該項目的IBM博士后研究員Stefano Ambrogio在接受采訪時告訴VentureBeat,“并且還有很多等待。”

科學家的解決方案包括模擬存儲器和傳統電子元件。由一對相變存儲器(PCM)單元組成的單個單元以及電容器和三個晶體管的組合對應于網絡中的各個神經元。PCM將重量數據存儲在存儲器中,其在晶體管和電容器中表示為電荷。

當網絡訓練時,電容器會更新重量,經過數千次循環后將它們傳輸到PCM。

電容器不能保持超過幾毫秒的值,但可以快速編程。PCM是一種非易失性存儲器,不需要外部電源來保存數據。

研究使用硬件PCM和軟件模擬組件的混合來設計基準,結果很有希望。該芯片每平方毫米的計算量比GPU高出100倍,而功耗卻低280倍。更令人印象深刻的是,它與各種計算機視覺任務中的Google TensorFlow機器學習框架的速度和準確性相匹配。

“我們可以以非常準確的方式進行[計算],與軟件的準確度相同,”Ambrogio說。

研究人員的芯片設計并非沒有重要的警告:它沒有針對未完全連接的神經網絡進行優化,例如用于尖端語音識別應用的長期短期記憶(LSTM)網絡。但研究人員計劃下一步解決這個問題。

Ambrogio相信他們將來能夠大規模建造物理芯片。他認為它們被用于訓練智能手機和其他目前缺乏必要計算資源的設備中的神經網絡。

“能夠在需要的地方直接處理AI會很好,”Ambrogio說。“當你能夠訓練模型時,你不需要將信息[發送到云端]或讓[設備]與其他東西進行通信,它可以立即對某些事情作出反應。

![峰值[地面]位移(關于峰值[地面]位移簡介) 峰值[地面]位移(關于峰值[地面]位移簡介)](http://www.138071.com/uploadfile/2023/0519/thumb_100_100_9c6242d266dc9a6c93748f36886890dc254_t.jpg)