您現在的位置是:首頁 >綜合 > 2021-04-30 11:14:35 來源:

谷歌大腦研究人員演示劫持神經網絡的方法

計算機視覺算法并不完美。就在本月,研究人員證明了一種流行的物體檢測API 可能會被人誤以為貓是“瘋狂的被子”和“玻璃紙”。不幸的是,這不是最糟糕的:他們也可能被迫計算圖像中的方塊,對數字進行分類,并執行除預期任務之外的任務。

在預印本服務器Arxiv.org上發表的題為“ 神經網絡的對抗性重編程 ”的論文中,谷歌人工智能研究部門Google Brain的研究人員描述了一種實際上重新編程機器學習系統的對抗方法。轉移學習的新形式甚至不需要攻擊者指定輸出。

研究人員寫道:“我們的結果[首次證明] ......可能會發生針對神經網絡重新編程的對抗性攻擊......” “這些結果證明了深度神經網絡中令人驚訝的靈活性和令人驚訝的脆弱性。”

以下是它的工作原理:惡意行為者可以訪問正在執行任務的對抗神經網絡的參數,然后以轉換的形式引入擾動或對抗數據,以輸入圖像。隨著對抗性輸入被饋送到網絡中,他們將其學習的功能重新用于新任務。

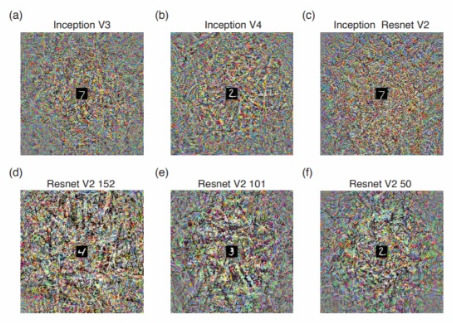

科學家在六種模型中測試了該方法。通過嵌入來自MNIST計算機視覺數據集的操縱輸入圖像(黑色幀和白色方塊的范圍從1到10),他們設法獲得所有六種算法來計算圖像中的方塊數,而不是識別像“白鯊”這樣的對象。 “鴕鳥。”在第二個實驗中,他們強迫他們對數字進行分類。在第三次也是最后一次測試中,他們讓模型識別來自CIFAR-10(一個物體識別數據庫)的圖像,而不是最初訓練它們的ImageNet語料庫。

糟糕的演員可以使用攻擊來竊取計算資源,例如,通過重新編程云托管照片服務中的計算機視覺分類器來解決圖像驗證碼 或挖掘加密貨幣。盡管該論文的作者沒有在復現神經網絡(一種常用于語音識別的網絡)中測試該方法,但他們假設成功的攻擊可能會導致這類算法執行“一系列非常大的任務”。

研究人員寫道:“對抗性程序也可以用作實現更傳統計算機黑客的新方法”。“例如,隨著手機越來越多地充當人工智能驅動的數字助理,通過將某人的手機暴露于對抗性圖像或音頻文件來重新編程,這種可能性會增加。由于這些數字助理可以訪問用戶的電子郵件,日歷,社交媒體帳戶和信用卡,因此此類攻擊的后果也會變得更大。“

幸運的是,這并不都是壞消息。研究人員指出,隨機神經網絡似乎比其他神經網絡更不容易受到攻擊,并且對抗性攻擊可以使機器學習系統更易于重新利用,更靈活,更高效。

即便如此,他們寫道,“未來的調查應該解決對抗性編程的特性和局限性以及防御它的可能方法。

![峰值[地面]位移(關于峰值[地面]位移簡介) 峰值[地面]位移(關于峰值[地面]位移簡介)](http://www.138071.com/uploadfile/2023/0519/thumb_100_100_9c6242d266dc9a6c93748f36886890dc254_t.jpg)