您現在的位置是:首頁 >人工智能 > 2021-04-28 08:36:08 來源:

幫助機器人處理不確定性

分散的部分可觀察馬爾可夫決策過程是一種模擬自主機器人行為的方式,在這種情況下,他們彼此之間的溝通以及他們對外部世界的判斷都不是完美的。

Dec-POMDPs(因為它們的縮寫)的問題在于它們和它們的名字一樣復雜。他們提供了最嚴格的多智能體系統數學模型 - 不僅僅是機器人,而是任何自治網絡設備 - 不確定性。但對于除了最簡單的情況之外的所有情況,它們都非常耗費時間來解決。

去年夏天,麻省理工學院的研究人員提交了一篇論文,使得Dec-POMDP對現實世界的機器人系統更加實用。他們表明,Dec-POMDP可以確定將現有的低級機器人控制系統拼接在一起以完成集體任務的最佳方式。通過為Dec-POMDP提供細節,這種方法使得它們在計算上易于處理。

在今年的機器人與自動化國際會議上,麻省理工學院的另一個研究小組將這一方法更進了一步。他們的新系統實際上可以從頭開始生成低級控制系統,同時仍能在合理的時間內解決Dec-POMDP模型。

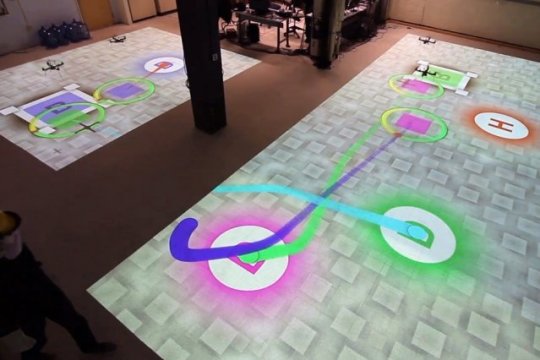

研究人員還在一小組機器人直升機上測試了他們的系統,模擬了亞馬遜和谷歌設想的無人機包裹遞送類型,但增加的限制是機器人無法相互通信。

“有一個離線計劃階段,代理人可以一起制定一個政策,說:'如果我采取這一系列行動,假設我在網上執行期間做了這些觀察,你采取其他一系列行動,鑒于你已經做了這些觀察,然后我們都同意我們采取的整套行動非常接近最優,“麻省理工學院航空航天研究生,新論文第一作者Shayegan Omidshafiei說。“在線階段沒有任何意義,代理商停下來說,'這是我的信念。這是你的信念。讓我們就最佳整體信念和重新計劃達成共識。' 每個人都做自己的事情。“

Dec-POMDP如此復雜的原因在于它們明確地考慮了不確定性。世界上的自主機器人可能依賴于其傳感器讀數來確定其位置。但是它的傳感器可能會略微容易出錯,因此任何給定的讀數都應該被解釋為定義圍繞實際測量的概率分布。

然而,即使是精確的測量也可以解釋,因此機器人需要在傳感器讀數的概率分布之上建立可能位置的概率分布。然后它必須選擇一個行動方案,但其可能的行動將有自己的成功概率。如果機器人參與協作任務,它還必須考慮其他機器人的可能位置及其隨后采取特定行動的可能性。

由于概率分布由一系列可能的值組成 - 原則上是無窮多的值 - 解決概率上的概率問題要比解決涉及離散值的問題困難得多。

為了更容易解決Dec-POMDP,Omidshafiei和他的合著者 - 他的論文顧問,Maclaurin航空航天教授Jonathan How; Ali-akbar Agha-mohammadi,麻省理工學院信息與決策系統實驗室前博士后現任高通研究所; 克里斯托弗·阿馬托(Christopher Amato)曾在麻省理工學院計算機科學與人工智能實驗室擔任博士后12月POMDP的早期工作,并剛剛加入新罕布什爾大學的教職員工 - 將其分解為兩個問題,兩個問題都涉及到圖表。

圖表是由節點組成的數據表示,通常描繪為圓圈和邊緣,通常描繪為連接圓圈的線條。網絡圖和家譜是熟悉的例子。

研究人員的算法首先構建一個圖表,其中每個節點代表一個“信念狀態”,意味著代理人自己的狀態和世界狀態的概率估計。然后,算法創建一組控制程序 - 圖形的邊緣 - 可以在信念狀態之間移動代理。

研究人員將這些控制程序稱為“宏觀行動”。因為單個宏動作可以在其起源和目的地處容納一系列信念狀態,所以規劃算法在將其傳遞到下一階段之前已經消除了一些問題的復雜性。

對于每個代理,該算法然后構造第二圖,其中節點表示在前一步驟中定義的宏動作,并且邊根據觀察結果表示宏動作之間的轉換。在新論文中報告的實驗中,研究人員隨后對代理人打算執行的任務進行了大量模擬,代理人在每次運行開始時采用不同的隨機狀態。基于代理每次執行其任務的程度,規劃算法為圖的節點處的宏動作和節點之間的轉換分配不同的權重。

結果是一個圖表,捕捉了一個代理人應該執行特定宏觀行動的概率,既考慮了過去的行為,又考慮了周圍世界的觀察。雖然這些概率基于模擬,但原則上,自治代理可以通過對其環境的物理探索來構建相同類型的圖。

最后,算法選擇具有最高權重的宏動作和轉換。這產生了各個代理可以遵循的確定性計劃:執行宏操作A后,如果進行測量B,則執行宏操作C.