您現在的位置是:首頁 >人工智能 > 2021-04-26 21:19:04 來源:

GelSight技術讓機器人可以測量物體的硬度并操縱小工具

八年前,麻省理工學院計算機科學與人工智能實驗室(CSAIL)的特德阿德爾森研究小組推出了一種名為GelSight的新型傳感器技術,該技術利用與物體的物理接觸來提供其表面非常詳細的三維地圖。

現在,通過將GelSight傳感器安裝在機械臂的夾具上,麻省理工學院的兩個團隊為機器人提供了更高的靈敏度和靈活性。研究人員上周在國際機器人與自動化會議上發表了兩篇論文。

在一篇論文中,Adelson的團隊使用GelSight傳感器的數據,使機器人能夠判斷其接觸的表面的硬度 - 如果家用機器人要處理日常物品,這是一項至關重要的能力。

另一方面,Russ Tedrake在CSAIL的機器人運動小組使用GelSight傳感器使機器人能夠操縱比以前更小的物體。

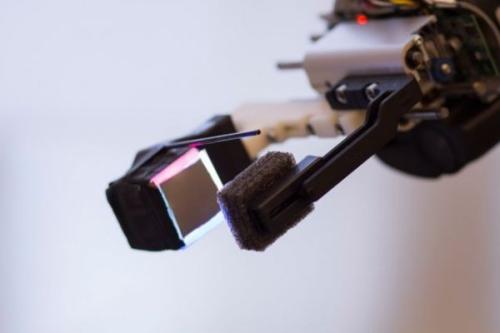

在某些方面,GelSight傳感器是解決難題的低技術解決方案。它由一塊透明橡膠組成 - 其名稱的“凝膠” - 其中一面涂有金屬漆。當涂漆面壓在物體上時,它符合物體的形狀。

金屬涂料使物體的表面反射,因此其幾何形狀變得更容易被計算機視覺算法推斷。安裝在橡膠塊涂漆面對面的傳感器上有三個彩色燈和一個攝像頭。

“[系統]有不同角度的彩色燈光,然后它有這種反光材料,通過觀察顏色,計算機......可以找出那個東西的三維形狀,”阿德爾森解釋說,約翰和Dorothy Wilson腦與認知科學系視覺科學教授。

在兩組實驗中,GelSight傳感器安裝在機器人抓手的一側,這種裝置有點像鉗子的頭部,但是具有平坦的抓握表面而不是尖頭。

聯絡點

對于自主機器人來說,測量物體的柔軟度或硬度對于決定在何處以及如何難以掌握它們以及它們在移動,堆疊或鋪設在不同表面時的行為方式至關重要。觸覺傳感還可以幫助機器人區分看起來相似的物體。

在以前的工作中,機器人試圖通過將物體放置在平坦表面上并輕輕地戳它們以查看物體的硬度來評估物體的硬度。但這不是人類測量硬度的主要方式。相反,我們的判斷似乎是基于物體和手指之間的接觸面積隨著我們按壓而變化的程度。較軟的物體往往會變平,增加接觸面積。

麻省理工學院的研究人員采用了相同的方 機械工程專業的研究生,阿德爾森集團的論文第一作者,文振媛使用糖果模具制作了400組硅膠制品,每組16件。在每組中,物體具有相同的形狀但硬度不同,元使用標準工業規模測量。

然后,她手動對每個物體按下GelSight傳感器,并記錄接觸模式隨時間的變化情況,從而為每個物體生成一個短片。為了使數據格式標準化并保持數據大小易于管理,她從每部電影中提取了五幀,在時間上均勻分布,描述了被按下的對象的變形。

最后,她將數據輸入神經網絡,自動尋找接觸模式變化與硬度測量之間的相關性。由此產生的系統將視頻幀作為輸入,并以非常高的精度產生硬度分數。袁還進行了一系列非正式實驗,其中人類受試者觸摸水果和蔬菜,并根據硬度進行排名。在每種情況下,裝有GelSight的機器人都達到了相同的排名。

她的兩位論文顧問阿德爾森和機械工程系高級研究科學家Mandayam Srinivasan參與了論文。去年夏天,清華大學的本科生陳卓卓訪問了阿德爾森的團隊; 和安德魯歐文斯,他在麻省理工學院攻讀電子工程和計算機科學博士學位,現在是加州大學伯克利分校的博士后。

視線受阻

從機器人步態集團紙誕生的集團的經驗與國防高級研究計劃局的機器人挑戰賽(DRC),其中學術和行業團隊競相發展,將引導人形機器人通過一系列相關的任務控制系統一個假設的緊急情況。

通常,自主機器人將使用某種計算機視覺系統來指導其對其環境中的對象的操縱。這樣的系統可以提供關于物體位置的非常可靠的信息 - 直到機器人拾取物體為止。特別是如果物體很小,它的大部分將被機器人的抓手遮擋,使得位置估計更加困難。因此,在機器人需要精確地知道物體位置的點處,其估計變得不可靠。這是麻省理工學院團隊在剛果民主共和國期間遇到的問題,當時他們的機器人必須拿起并打開電鉆。

“你可以在我們的視頻中看到DRC我們花了兩三分鐘開始演練,”電子工程和計算機科學研究生,新論文的第一作者Greg Izatt說。“如果我們有一個實時更新,準確估計鉆頭的位置和我們的手相對于它的位置,那將會更好。”

這就是機器人運動集團轉向GelSight的原因。Izatt和他的合著者 - Tedrake,豐田電氣工程和計算機科學,航空航天和機械工程教授; 阿德爾森; 另外,Tedrake團隊的另一名研究生Geronimo Mirano設計了一種控制算法,該算法利用計算機視覺系統將機器人的夾具引向工具,然后在機器人手持工具后將位置估算轉換為GelSight傳感器。

通常,這種方法的挑戰是將視覺系統產生的數據與觸覺傳感器產生的數據進行協調。但GelSight本身就是基于攝像頭的,因此與其他觸覺傳感器的數據相比,其數據輸出更容易與可視化數據集成。

在Izatt的實驗中,配備GelSight的夾具的機器人必須抓住一把小螺絲刀,將其從皮套中取出并將其送回。當然,來自GelSight傳感器的數據并沒有描述整個螺絲刀,只是它的一小部分。但Izatt發現,只要視覺系統對螺絲刀初始位置的估計精確到幾厘米之內,他的算法就可以推斷出GelSight傳感器所接觸的螺絲刀的哪一部分,從而決定了螺絲刀在機器人手中的位置。

“我認為GelSight技術以及其他高帶寬觸覺傳感器將對機器人產生重大影響,”加州大學伯克利分校電子工程和計算機科學助理教授Sergey Levine說。“對于人類來說,我們的觸覺是我們驚人的手動靈巧的關鍵因素之一。目前的機器人缺乏這種靈巧性,并且在操縱物體時對表面特征的反應能力有限。如果你想象在黑暗中摸索一個燈開關,從口袋中提取物體,或者你甚至不用思考就可以做任何其他許多事情 - 這些都依賴于觸摸傳感。

“軟件最終正在追趕我們傳感器的功能,”Levine補充道。“受深度學習和計算機視覺創新啟發的機器學習算法可以處理來自傳感器(如GelSight)的豐富感官數據,以推斷出對象屬性。在未來,我們將看到這些學習方法融入端到端訓練的操作技能,這將使我們的機器人更加靈巧和有能力,并可能幫助我們了解我們自己的觸覺和電機控制感。