您現在的位置是:首頁 >市場 > 2020-12-10 10:39:39 來源:

一種深度學習技術可為實時2D動畫生成實時口型同步

實時二維動畫是一種相當新穎而強大的交流形式,它使人類表演者可以實時控制卡通人物,同時與其他演員或觀眾互動和即興表演。最近的例子包括史蒂芬·科爾伯特(Stephen Colbert)在《后期秀》中采訪卡通客人,荷馬在《辛普森一家》(The Simpsons)的一段節目中回答觀眾的現場電話提問,阿切爾(Archer)在ComicCon上與現場觀眾交談,以及迪斯尼的《星際大戰:邪惡力量》和My Little Pony通過YouTube或Facebook Live與粉絲主持實時聊天會話。

制作逼真的,有效的實時二維動畫需要使用交互式系統,該系統可以自動將人類表演實時轉換為動畫。這些系統的一個關鍵方面是獲得良好的口型同步,這實質上意味著動畫人物的嘴巴在說話時會適當移動,模仿在表演者的嘴巴中觀察到的動作。

良好的口型同步可以使實時2D動畫更具說服力和功能強大,使動畫角色可以更真實地體現性能。相反,不良的口型同步通常會破壞角色作為現場表演或對話參與者的幻覺。

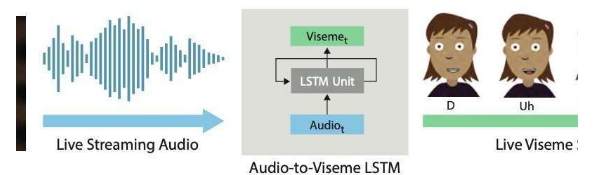

在最近的論文預先公布的上的arXiv,兩位研究人員在研究的Adobe和華盛頓大學推出了深基礎的學習互動系統,可自動生成分層2 d動畫人物活唇音同步。他們開發的系統使用了長期短期記憶(LSTM)模型,一種遞歸神經網絡(RNN)架構,該架構通常應用于涉及對數據進行分類或處理以及進行預測的任務。

“由于語音幾乎是每個實時動畫的主要組成部分,因此我們認為在這一領域要解決的最關鍵的問題是實時口型同步,這需要將演員的語音轉換為動畫角色中相應的嘴部動作(即視位序列)。在這項工作中,我們致力于為實時2D動畫創建高質量的口型同步。”進行這項研究的兩位研究人員Wilmot Li和Deepali Aneja通過電子郵件告訴TechXplore。

Li是Adobe Research的首席科學家,擁有博士學位。計算機科學領域的一位學者,他一直在計算機圖形學與人機交互的交叉點上進行廣泛的研究。另一方面,Aneja目前正在完成博士學位。她是華盛頓大學計算機科學與圖形圖像實驗室的成員。

Li和Aneja開發的系統使用簡單的LSTM模型,以每秒24幀的速度將流音頻輸入轉換為相應的視位音素序列,并且延遲不到200毫秒。換句話說,他們的系統允許動畫人物的嘴唇以與人類用戶實時說話類似的方式移動,而聲音和嘴唇移動之間的延遲小于200毫秒。