您現在的位置是:首頁 >要聞 > 2021-01-14 08:23:11 來源:

概念美白一種提高圖像識別模型可解釋性的策略

導讀 在過去的十年左右的時間里,深度神經網絡在包括圖像識別任務在內的各種任務上都取得了非常有希望的結果。盡管它們具有優勢,但它們卻非常復

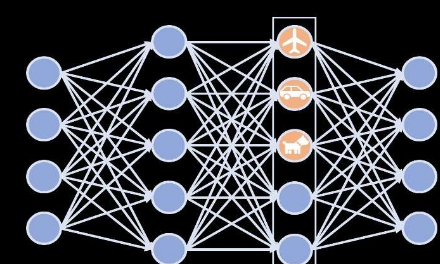

在過去的十年左右的時間里,深度神經網絡在包括圖像識別任務在內的各種任務上都取得了非常有希望的結果。盡管它們具有優勢,但它們卻非常復雜和復雜,這使得解釋他們學到的知識以及確定其預測背后的過程變得困難甚至有時是不可能的。缺乏可解釋性使得深度神經網絡有些不可信任且不可靠。

由Cynthia Rudin教授領導的杜克大學預測分析實驗室的研究人員最近設計了一種可以改善深度神經網絡的可解釋性的技術。這種方法稱為概念美白(CW),最早是在《自然機器智能》上發表的一篇論文中介紹的。

“我們沒有進行事后分析來查看NN的隱藏層,而是直接更改NN來使潛空間解開,以便使軸與已知概念對齊,”進行這項研究的研究人員之一陳智,告訴Tech Xplore。“這種糾纏可以使我們對網絡如何逐步學習層上的概念有了更清晰的了解。它還集中了有關一個概念(例如“燈”,“床”或“人”)的所有信息,僅通過一個神經元;這就是解纏的意思。”

最初,Rudin和她的同事們設計的技術解開了神經網絡的潛在空間,使它的軸與已知概念對齊。從本質上講,它執行“白化轉換”,類似于將信號轉換為白噪聲的方式。此轉換對潛在空間進行去相關。隨后,旋轉矩陣從戰略上將不同的概念與軸進行匹配,而無需反轉該去相關性。