您現在的位置是:首頁 >要聞 > 2020-12-02 08:18:46 來源:

縮小用于建模語言的大規模神經網絡

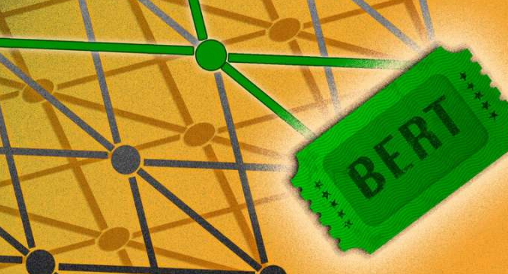

喬納森·弗蘭克(Jonathan Frankle)正在研究人工智能,而不是開心果,但同樣的哲學也適用于他的“彩票假設”。它假定,隱藏在大規模神經網絡中的精益子網可以更有效地完成相同的任務。訣竅是找到那些被稱為中獎彩票的“幸運”子網。

在一篇新論文中,Frankle及其同事發現了潛伏在BERT中的此類子網,BERT是一種用于自然語言處理(NLP)的先進神經網絡方法。作為人工智能的一個分支,NLP旨在通過預測文本生成或在線聊天機器人等應用程序來解密和分析人類語言。在計算方面,BERT體積龐大,通常需要大多數用戶無法獲得的超級計算能力。可以使用BERT的中獎彩票,可以公平競爭,從而可能使更多用戶在智能手機上開發有效的NLP工具,而無需使用大錘。

弗蘭克勒說:“我們正在達到必須使這些模型更精簡,更高效的地步。”他補充說,這一進步有一天可能會“減少NLP的準入門檻”。

Frankle博士 該研究的共同作者是麻省理工學院計算機科學與人工智能實驗室的邁克爾·卡賓小組的學生,該研究將于下個月在神經信息處理系統會議上發表。德克薩斯大學奧斯汀分校的陳天龍是該論文的主要作者,其中包括得克薩斯州A&M的合作者Wang Zhangyang Wang,以及所有MIT-IBM Watson AI Lab的常石宇,劉思佳和張揚。

您今天可能已經與BERT網絡進行了互動。這是Google搜索引擎的基礎技術之一,自Google于2018年發布BERT以來,它一直引起研究人員的興奮。BERT是一種創建神經網絡的方法,即使用分層節點或“神經元”的算法來學習執行神經網絡。通過培訓大量實例來完成任務。BERT是通過反復嘗試填寫寫作段落中遺漏的單詞來進行訓練的,它的功能在于此初始訓練數據集的龐大大小。然后,用戶可以將BERT的神經網絡微調至特定任務,例如構建客戶服務聊天機器人。但是爭吵的BERT需要大量的處理能力。