您現在的位置是:首頁 >要聞 > 2020-11-20 08:34:10 來源:

神經網絡學習何時不應該信任它

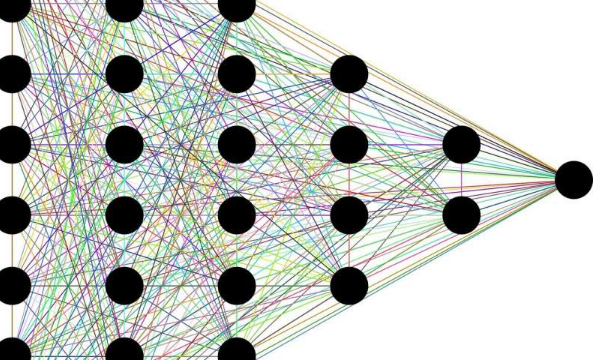

越來越多地,被稱為深度學習神經網絡的人工智能系統用于告知對人類健康和安全至關重要的決策,例如在自動駕駛或醫療診斷中。這些網絡擅長識別大型復雜數據集中的模式以幫助決策。但是,我們怎么知道它們是正確的呢?亞歷山大·阿米尼(Alexander Amini)和他在麻省理工學院和哈佛大學的同事希望找出答案。

他們為神經網絡開發了一種處理數據的快速方法,不僅可以輸出預測,還可以基于可用數據的質量輸出模型的置信度。這種進步可能會挽救生命,因為當今的現實世界已經部署了深度學習。網絡的確定性級別可以是自動駕駛汽車確定“很明顯可以通過交叉路口”和“很可能已經清楚,因此以防萬一”之間的區別。

用于神經網絡的不確定性估計的當前方法在計算上趨于昂貴并且對于瞬間決策而言相對較慢。但是阿米尼的方法被稱為“深度證據回歸”,可以加快這一過程,并可能導致更安全的結果。“我們不僅需要擁有高性能模型的能力,而且還需要了解我們何時無法信任那些模型的能力,”博士Amini說。麻省理工學院計算機科學與人工智能實驗室(CSAIL)的Daniela Rus教授小組的學生。

“這個想法很重要,并且廣泛適用。它可以用于評估依賴于學習模型的產品。通過估計學習模型的不確定性,我們還可以了解模型會帶來多少誤差,以及哪些缺失數據可以改善模型的誤差。模型。” Rus說。

Amini將與Rus一起在下個月的NeurIPS會議上介紹這項研究,Rus是安德魯和厄納·維特比(Andrew and Erna Viterbi)的電氣工程和計算機科學教授,CSAIL的負責人,也是麻省理工學院斯蒂芬·A·施瓦茨曼計算機學院的副院長。麻省理工學院的研究生Wilko Schwarting以及麻省理工學院和哈佛大學的Ava Soleimany。

有效的不確定性

縱觀歷史,深度學習在各種任務上都表現出卓越的性能,在某些情況下甚至超過了人類的準確性。如今,深度學習似乎隨計算機而去。它為搜索引擎結果,社交媒體供稿和面部識別提供了動力。“我們在使用深度學習方面取得了巨大的成功,” Amini說。“神經網絡確實擅長于99%的時間知道正確的答案。” 但是有99%的人無法挽救生命。

阿米尼說:“使研究人員無法理解的是,這些模型能夠知道并告訴我們何時可能出錯。” “我們真的很在意這1%的時間,以及我們如何可靠,有效地檢測到這些情況。”

神經網絡可能非常龐大,有時會充滿數十億個參數。因此,僅僅為了獲得答案可能是繁重的計算工作,更不用說置信度了。神經網絡中的不確定性分析并不新鮮。但是以前的方法基于貝葉斯深度學習,已經多次依賴運行或采樣神經網絡來了解其信心。該過程需要時間和內存,這在高速流量中可能并不存在。

研究人員設計了一種方法,可以僅通過一次神經網絡來估計不確定性。他們設計了具有大量輸出的網絡,不僅生成決策,而且還收集了新的概率分布,以收集支持該決策的證據。這些分布稱為證據分布,直接捕獲了模型對其預測的信心。這包括基礎輸入數據以及模型的最終決策中存在的任何不確定性。這種區別可以表明是否可以通過調整神經網絡本身來減少不確定性,或者輸入數據是否只是噪聲。