您現在的位置是:首頁 >要聞 > 2020-11-19 16:48:11 來源:

一項新研究教給AI人如何通過互聯網視頻移動

密歇根大學的一項新研究可以訓練神經網絡模型,以識別視頻中某個人的身體部位,而這些人的身體中只有一部分在鏡頭中可見。這項突破性發展為新的用途打開了一個龐大的視頻內容庫—教人們姿勢背后的含義以及人們與環境互動的不同方式的機器。

當我們看到兩只手在桌子上打字的圖片時,我們可以推斷出有一個人附著在那些看不見的地方。根據他們的手腕角度和桌子的高度,我們甚至可以判斷他們是坐著還是站著。到目前為止,神經網絡模型還不是很好。如果我們希望機器人和AI能夠通過觀察我們的眼睛就能告訴我們正在做什么,那么他們將需要對我們的身體在不同環境中的位置以及不同動作通常意味著什么有更深入的了解。

研究領域稱為人體姿勢估計,其重點是教AI識別圖像或視頻中人物的位置,最終使他們能夠獨立地建模這些人物的位置。但是,當前的模型通常是在非常干凈的視頻庫中訓練的,整個人都可以看到,并且在只有一部分人可見的情況下拍攝效果很差。

最重要的是,所使用的視頻都帶有標簽-本質上,這些視頻帶有提供的正確解決方案,以便神經網絡能夠檢查其工作。在這種情況下,這需要人工來明確標記顯示人員的關節位置。

David Fouhey教授和博士 學生克里斯·羅克韋爾(Chris Rockwell)看到了這種做法的問題-在上傳到公共網站的龐大視頻內容庫中,只有大約4%的人直截了當地展示了整個人。而且,當然,它們都沒有標簽。這意味著視頻的整個世界幾乎都被這些舊模型所封閉,新的視頻將必須量身定制并手動標記才能使神經網絡成功。

羅克韋爾說:“這些數據集在某種程度上被歸一化,即一個人處于一定高度,并且他們位于圖像的中心。” “互聯網上的東西實際上并不是那樣。”

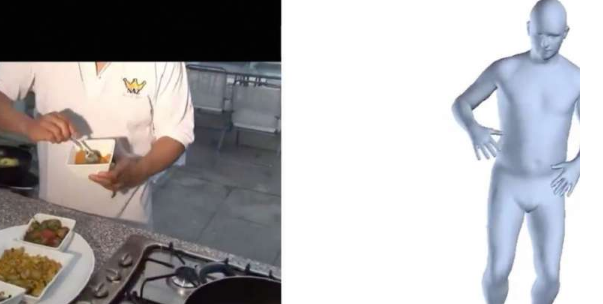

為了克服這些限制,Rockwell和Fouhey提出了一對解決方案,該解決方案在2020年歐洲計算機視覺會議上發表。該技術最終在神經網絡模型的視頻訓練中帶來了兩個重大突破:使模型能夠在只有一部分人可見的情況下做出良好的預測,以及在未標記的視頻上對這些模型進行自我訓練,其中模型可以巧妙地挑出良好的猜測沒有被告知解決方案。

首先,他們必須解決在這些截斷的人像上訓練的神經網絡性能不佳的問題。為此,他們采取了直觀的步驟來裁剪網絡的早期培訓集,使其看起來更像您在網上找到的視頻。兩人拍攝了一次全身活動的視頻,并將其縮小為軀干,頭部或手臂。現有模型已在這些作物上進行了重新訓練,然后可以使用互聯網視頻中的新數據生成更合理的輸出。

研究人員指出,該技術的直接設計使該方法在廣泛使用時更加靈活。