您現在的位置是:首頁 >綜合 > 2021-05-06 22:09:32 來源:

Nvidia推出大量AI處理芯片Tesla V100

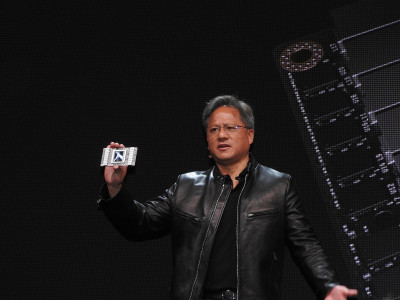

Nvidia首席執行官Jen-Hsun Huang為人工智能應用推出了一款雄心勃勃的全新處理器Tesla V100。

這款新芯片擁有210億個晶體管,比一年前Nvidia宣布的150億個基于Pascal的處理器強大了一個數量級。這是一塊巨大的芯片 - 815平方毫米,或者像Apple Watch那樣大。它有5,120個CUDA處理內核,并且在7.5 FP64 teraflops下運行。性能大約是去年產品的三倍。

總部位于加利福尼亞州圣克拉拉的Nvidia是最大的圖形和AI芯片制造商,它在加利福尼亞州圣何塞舉行的GPU技術大會上宣布了這一消息。

了解開發商和品牌營銷人員如何利用人工智能發展他們的業務,將于7月11日至12日在SF的MB中展示。我們通過大肆宣傳來展示營銷人員如何實現真正的投資回報率。在5月19日之前享受早鳥優惠 50%%的優惠!

在介紹芯片之前,黃先生追溯了人工智能的近期歷史。他指出,深度學習神經網絡研究大約在五年前開始取得成效,當時研究人員開始使用圖形處理單元(GPU)并行處理數據以快速訓練神經網絡。從那時起,深度學習的步伐加快了。而今年,Nvidia計劃培訓100,000名開發人員使用深度學習。

對于深度學習,特斯拉V100,也稱為Volta,可以處理120張Tensor teraflops。它可以以每秒300千兆位的速度傳輸數據,或者比現在的其他處理器快20倍。它由三星為Nvidia制造。

與去年基于Pascal的處理器相比,Volta的Tensor FLOP用于深度學習訓練的12倍。由于深度學習算法的驚人進步,這種處理速度是必要的。

2015年,微軟創建了一個名為ResNet的深度學習程序,它非常復雜,需要7個exaflops的處理能力。2016年,百度的Deep Speech 2 AI需要20次exaflops,而2017年Google的NMT需要105次exaflops。

微軟正在開發一個新版本的ResNet,它將64個Volta芯片連接在一起進行處理。目前還不清楚Volta何時將大量出貨。