您現在的位置是:首頁 >生活 > 2020-11-27 09:21:22 來源:

探索機器人技術中聲音動作和視覺之間的相互作用

導讀 近年來,研究人員開發了越來越多的計算技術,以使機器人具有類似人的能力。但是,到目前為止開發的大多數技術都只專注于人為地再現視覺和觸

近年來,研究人員開發了越來越多的計算技術,以使機器人具有類似人的能力。但是,到目前為止開發的大多數技術都只專注于人為地再現視覺和觸覺,而忽略了諸如聽覺感知之類的其他感覺。

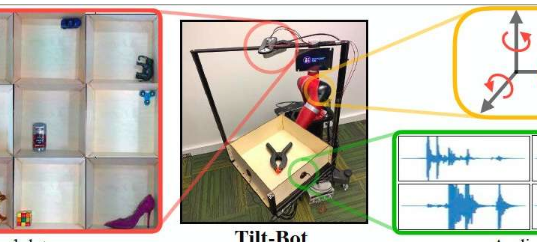

卡內基梅隆大學(CMU)的研究小組最近進行了一項研究,探討了使用聲音開發具有更先進傳感功能的機器人的可能性。他們的論文發表在《機器人技術:科學與系統》上,介紹了迄今為止編譯的最大的聲音動作視覺數據集,該數據集是作為一個稱為Tilt-Bot的機器人平臺收集的,并且可以與各種各樣的對象進行交互。

“在機器人學習中,我們通常僅使用視覺輸入進行感知,但是人類擁有的感知方式不僅僅是視覺。”進行這項研究的研究人員之一Lerrel Pinto對TechXplore說。“聲音是學習和了解我們的物理環境的關鍵組成部分。因此,我們提出了一個問題:聲音可以用機器人學買我們嗎?為了回答這個問題,我們創建了Tilt-Bot,該機器人可以與物體互動并收集物體。互動的大規模視聽數據集。”

本質上,Tilt-Bot是一種自動托盤,可以傾斜物體,直到它們碰到托盤的一面墻為止。Pinto和他的同事們在機械手托盤的墻壁上放置了接觸式麥克風,以記錄物體撞擊墻壁時產生的聲音,并使用高架攝像頭直觀地捕捉每個物體的運動。

研究人員收集了與60個不同對象進行的超過15,000次Tilt-Bot交互的視覺和音頻數據。這使他們能夠編譯一個新的圖像和音頻數據集,這有助于訓練機器人在動作,圖像和聲音之間建立關聯。

Pinto和他的同事在論文中使用此數據集來探索機器人應用程序中聲音與動作之間的關系,并收集了許多有趣的發現。首先,他們發現分析物體移動和撞擊表面的聲音記錄可以使機器區分不同的物體,例如區分金屬螺絲刀和金屬扳手。